数据中心网络特征- IT网络运维

2020-05-05 18:33 作者:艾锑无限 浏览量:

对于我们IT网络运维来说,新一代云计算数据中心是一个高密度,大容量的网络应用场合,所以对网络的带宽、端口密度、安全防护、管理等各方面都提出了严峻的考验。比如基于云计算应用的数据中心流量再也不像传统数据中心只是有简单的汇聚型流量,相对固定的交互流量,而是呈现高度的不定向突发性,传统城域网交换机的性能难以满足;比如数据中心设备高密度摆放,传统城域网交换机横插板的左右风道设计因此不能满足绿色节能的要求等等。作为我们网络运维必须了解这些新的架构。新的应用趋势要求新一代数据中心的网络应具有如下关键特征。

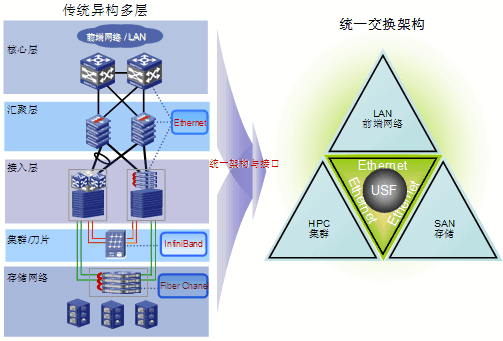

统一交换

新一代云计算数据中心将存在计算网、存储网、业务网三张网,如果按原来建网方式,将可能会建设三张采用Infiniband、Fiber Chanel、Ethernet不同技术的网络,其不仅大大增加建设与维护成本,而且技术异构的网络将无法实现统一的虚拟化,从而难以实现真正意义上的云计算。幸运的是,随着以太网技术的发展以及整个产业链的成熟,Ethernet已经可以取代甚至超越Infiniband、Fiber Chanel网络,我们可以采用基于Ethernet的统一交换网来建设新一代数据中心,从而构建真正的云计算平台。

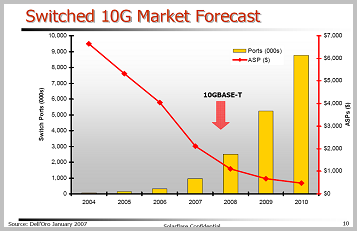

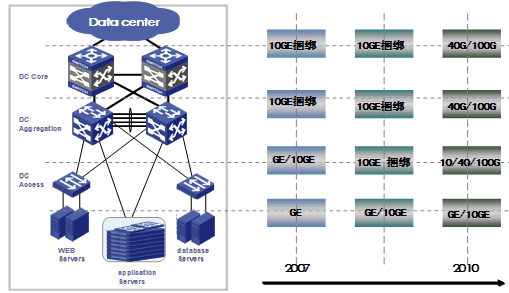

万兆端口密度

从服务器数量上看,数据中心呈现一个明显的发展规律———万台服务器规模的数据中心将是发展主流。同时,随着单台服务器集成的计算核数量的增长,其消耗的带宽也同步增长,而10GE网卡采的硬件加速技术(TCP offload, iSCSI offload, RDMA acceleration)使服务器的吞吐能力接近线速。Gartner及Dell’Oro预测2006-2010年10GE交换端口的年增长率超过100%。

40G/100G接口支持能力

现在相当多的数据中心出口带宽已达到100G以上,并且还在以每年50%-400%的速度增长。如果采用传统的10G接口,则要用16-40个端口捆绑才能满足未来一至两年的需求。采用如此多的端口进行捆绑不仅消耗了大量宝贵的光纤资源,而且大大增加了管理维护的工作量。随着40G/100G标准的最终定稿,可以预见一场40G/100G接口的普及风暴很快就会到来。

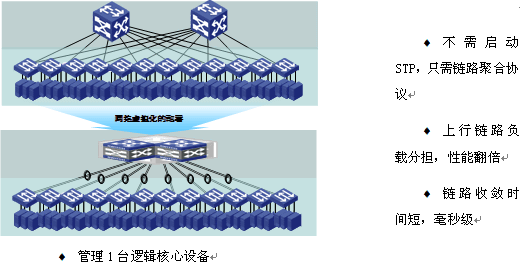

云计算不仅仅需要服务器与存储实现虚拟化,网络同样需要与时俱进,能实现虚拟化。虚拟化的网络不仅可以实现网络资源的动态调配,在线扩充,简化网络配置与管理,而且可以大大提高数据中心网络的可靠性。

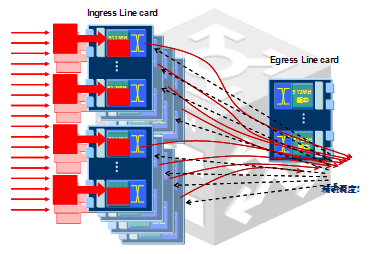

由于不同时刻各服务器上分布的应用都是动态调配的,而且服务器与服务器之间自动交互的频繁度也将比现在独立的应用时要高得多,所以云计算环境下的流量特征将比现在的多媒体流量环境下更为复杂、更难预测,突发性也将更明显。所以云计算数据中心的网络必须选用专门的数据中心级交换机来架构。与传统的城域网交换机相比,数据中心交换机有几个突出优点,从而能满足云计算数据中心这种严酷的环境。

(1)完全无阻塞交换网:数据中心级交换机采用CLOS交换网,这是一种完全无阻塞交换架构,从而保证在任何流量特征的环境下,交换网都是可以实现无阻塞交换。

(2)分布式大缓存:云计算环境下,机机交互的频率大大增加,从而使得瞬间多端口向一端口转发的机率也大大增加,流量的突发性非常严重。传统的城域网交换机一般仅在出端口方向装配有很小的缓存,通常每板只有32-64M,缓存时间只有10-20mS左右。遇到多端口向单一端口转发流量时,一个端口本来就很小的缓存还要应对多端口的流量冲击,迅速就发生缓存拥塞丢包。而丢包后,将会引起应用层的重传,从而进一步导致更严重的网络拥塞。数据中心级交换机采用入端口分布式大缓存的革新架构,其平均每个10G端口的入缓存可达256M,GE端口的缓存达20M,从而保证在任何流量模型情况下,端口缓存时间最大均可达到200mS以上,为云计算的应用提供了一个扎实的网络基础。

随着越来越多的终端设备接入网络,网络IPv4地址已将消耗殆尽,从IPv4向IPv6的全面演进已迫在眉睫。作为新一代数据中心网络,支持IPv4/IPv6的双栈接入也是必然的要求,并且要求对IPv4/IPv6均要能提供线速的转发能力,高性能、灵活地实现两个网络互访。

绿色节能

数据中心已经成为耗能大户,如何才能建设一个绿色节能的数据中心已经成为关注的重点。数据中心的节能是一个系统工程,IT设备功耗占总体能耗的31%左右,而空调、冷风机等的能耗占了40%左右。所以不仅IT设备本身的功耗,而且IT设备对空调、冷风机的功耗影响也是需要关注的重点。

根据TIA-942标准及业内实践来看,采用下送风专用机柜,背对背方式排列,冷风在机柜底部前边进风,进入数据设备后热风在数据机柜后侧排出,与上送风形式相比空调风机耗电量节省30%。所以绿色数据中心设备都要求是竖插槽,后端下进风,上端前出风的设备,以满足数据中心整体布局要要求。

艾锑无限科技专业:IT外包、企业外包、北京IT外包、桌面运维、弱电工程、网站开发、wifi覆盖方案,网络外包,网络管理服务,网管外包,综合布线,服务器运维服务,中小企业it外包服务,服务器维保公司,硬件运维,网站运维服务

以上文章由北京艾锑无限科技发展有限公司整理

相关文章

关闭

关闭